互联网大数据、人工智能技术( Artificial Intelligence )像当初的原油、电力工程一样, 正以史无前例的深度广度和深层危害全部的领域, 如今及将来企业的关键堡垒是数据信息, 竞争优势来源于根据互联网大数据的人工智能技术的市场竞争。因此无论是软件工程专业的程序猿,还是是非非软件工程专业提前准备改行电子计算机的转账工作人员都想学习大数据,从业java开发工作中。

可是如果你立在一个领域门口的情况下,你大量的是见到他的使用价值和市场前景,这会促进你不顾一切地往里冲。但如果你要想超越这道门坎新手入门的情况下,你逐渐考虑到技术性方面的艰难,哪些艰难呢?那就是我对这一领域了解很少,这一领域是不是和我的想像相符合?是不是与我的发展前景一致?我该从哪里逐渐?应当怎样快速入门?

互联网大数据这一领域也是一样,仿佛这一网络时代,不清楚互联网大数据就过时了一样,但许多一部分人也只仅限于了解了互联网大数据这个词,并再加上自身想像的界定。

那麼互联网大数据究竟是什么?用于干什么?怎么开始互联网大数据的学习培训呢?今日大家从技术性的视角来从入门到精通聊一聊。

最先,互联网大数据究竟是什么?互联网大数据仅仅一个通称。理论上,像java开发、数据分析、大数据分析等对互联网大数据的实际操作都能够通称为互联网大数据。小范围上:互联网大数据就是指在一定时间段内没法用基本的手机软件分析工具开展解决的数据。因此从界定能看出去,互联网大数据最初的实质实际上便是数据,仅仅数据的经营规模、规模非常大,大到我们无法接纳应用基本手机软件解决所耗费的時间。

互联网大数据用于干什么?大家早已确立了互联网大数据便是数据,那麼数据用于干什么,自然是根据对数据开展解决、剖析,获取有效的信息内容用以各种各样业务流程当中。因此互联网大数据的功效也是这般,根据获取互联网大数据中有使用价值的信息内容,再运用这种信息内容开展业务流程颠覆式创新,推动新型智慧城市基本建设、公司客户画像、人工智能技术仿生技术、诊疗疾患诊断等政、企、研、医领域的发展趋势,为行业领域产生新的使用价值室内空间。

即然互联网大数据有这般多的应用领域、宽阔想像室内空间的发展前途,那麼怎么开始触碰学习大数据呢?

为了更好地大伙儿可以真真正正搞清楚,也为了更好地可以做到从入门到精通的实际效果,大家在下面表明互联网大数据的各种各样解决方式的时候会常常拿基本数据信息和互联网大数据来比照表述。

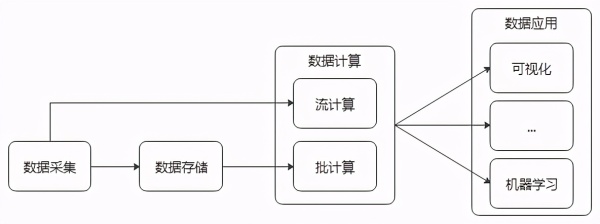

最先互联网大数据的数据信息特性就决策了他的实际操作室内空间(解决步骤),不外乎数据收集→数据储存→数据信息测算→数据信息运用。这种实际操作的身后基本上包含了当今互联网行业的全部全产业链。

数据融合步骤

大数据采集是互联网大数据全部管理体系的起止端。大家最先必须 读取数据,传统式数据信息的获得方法,例如学生电子档案的获得,我们可以选用Excel手写功能的方法获得。可是在这个网络时代,动则上万条、千条万条数据信息,又有各式各样的数据库,比

如数据库查询、日志、物联网技术感应器这些,大家不太可能再根据人力或基本Excel的方法去即时获得、归纳数据信息,此刻就必须 对于这类超出一般数据界定的超大型数据选用专业的采集软件,来提升数据收集高效率,使每秒钟造成的不计其数数据信息可以立即被收集到特定的移动存储设备上,不造成数据信息库存积压,防止导致内容丢失。应用专业采集软件高效率采集数据的全过程就被称为大数据采集。大数据采集,依据收集的数据库不一样(数据库查询、日志、物联网技术数据信号...),收集的基本数据类型不一样(非结构化数据、半非结构化数据、非非结构化数据),会采用众多融入于分别情景的采集软件,例如:Flume、Sqoop、Nifi...

Flume是Cloudera给予的(之后变成Apache开源软件)一个高可用性,高靠谱的,分布式系统的大量日志收集、汇聚和传送的专用工具。关键用以收集日志类数据信息,因为Flume能够根据配备收集端收集方式(spooldir、exec)进而能够保证文件名称内增加文档的增加量收集、文档内增加文档內容的增加量收集。Flume还能够根据配备自定拦截器,过虑不用的字段名,并对特定字段名数据加密解决,将源数据信息开展预备处理,完成数据脱敏。

Sqoop是在Hadoop(后边会详细介绍)绿色生态管理体系和RDBMS管理体系中间传输数据的一种专用工具。最常见的或是根据Sqoop将RDBMS管理体系(Mysql、Oracle、DB2等)中的非结构化数据收集并储存到Hadoop管理体系(HDFS、Hive、Hbase等)的数据库管理中。

Nifi,因为Nifi能够对来源于多种多样数据库的流数据开展解决,因而普遍被运用于物联网技术(IoAT)的数据处理方法。

根据上边的流行专用工具,大家大部分能处理99%种情景下的数据收集工作中,数据收集完以后,就需要遭遇一个迫不得已考虑到的难题:收集的数据信息存有哪儿?

基本数据信息能够存有电脑硬盘、存有传统式单机版数据库查询。但互联网时代呢?因为信息量爆发式的提高,每块电脑硬盘或单机版数据库查询早已达到不上大家的储存规定了,大家必须 更高的储存空间,要可以伴随着数据信息的提高而提升室内空间,使大家的数据信息所有存到不外溢。那样就会有2个方位:一个是堆硬件配置,提高硬件配置品质,开发设计更高储存工作能力的电脑硬盘或移动存储设备;一个是堆总数,找更几块电脑硬盘来把数据信息按块储放在不一样的电脑硬盘上。

互联网大数据的储存解决方法便是第二种,挑选更为便宜、高效率、可拓展的横着拓展方法来达到数据储存。即然挑选堆总数的方法来储存大量级的数据信息,那么就还需要处理一个难题,那便是查看难题。数据信息能够分次放进不一样的电脑硬盘中,我获得的情况下怎样精确迅速的寻找要想的那一条数据信息,放到哪一个盘、哪一个文档的第两行呢?这就必须 技术专业的大数据存储专用工具来处理这种难题,完成分布式系统状况下每台连接点信息量的均衡、数据信息服务器集群避免 内容丢失、数据信息创建数据库索引完成快速搜索等。现阶段互联网大数据中采用的流行分布式存储有什么呢?例如:HDFS、HBase、Alluxio...

HDFS是Hadoop三大部件之一(此外2个部件分别是:资源优化配置部件——YARN,并行处理部件——MapReduce),是一个分布式系统的文档分布式存储,在大数据存储系统软件中具备不可替代的功效。从各种各样数据库收集的数据信息一般全是储存在HDFS,HDFS适用数据信息的增删,类似传统式数据库查询,但是在大信息系统中,大家称作“数据库管理”。

HBase是一个分布式系统的NoSql数据库查询,分布式系统的特性及其朝向列的储存特点,促使HBase在大数据存储行业运用普遍,关键用以储存一些半非结构化数据和非非结构化数据,而且能够融合phoenix(有兴趣的盆友能够自主百度搜索掌握)来完成二级数据库索引。

Alluxio本来称为Tachyon,是一个根据运行内存的分布式存储。它是构架在最底层分布式存储(例如:HDFS、Amazon S3等)和顶层分布式计算架构中间(例如后边会提及的MR、Spark、Flink等)的一个分布式数据库,工作职责是以文档方式在运行内存或其他移动存储设备中给出的数据的存储服务项目,降低数据信息IO特性耗费,加速测算模块载入数据信息的速率。

假如数据收集以后,仅仅储存在数据库管理当中,那麼这种数据信息沒有一切使用价值,也没法促进、推动大家的业务流程。因此,数据储存以后,便是要考虑到数据信息测算的难题了。数据信息如何计算呢?传统式的手机软件分析系统Excel、Mysql等没法安装大量数据的分析,由于设计方案之初,充分考虑的数据信息发布就远远地达不上互联网大数据的新手入门门坎规范。大家就需要寻找一些技术专业的大信息量的剖析计算软件来解决不一样特性数据的数据信息测算。数据信息测算从解决高效率来分,能够分成:线下批处理命令、并行处理。假如从处理方法来分,能够分成:数据统计分析、大数据挖掘。

大家先以线下批处理命令和并行处理2个视角来掌握数据信息测算解决专用工具。

互联网大数据盛行之初,大家对数据处理方法的及时性沒有如今规定那麼高,更为重视時间和成本费的均衡,基本上仅仅朝向“天”为粒度分布的线下测算情景,便是在第二天才逐渐解决前一天的数据信息。在这类情景下就问世了MapReduce,Hadoop三大部件中的并行处理部件。MapReduce测算主要是运用硬盘来开展正中间結果数据信息的储存,那样就导致数据信息的测算全过程,数据信息持续在运行内存和硬盘间IO,危害了测算高效率,在一些信息量较为大的状况下,一个MR(MapReduce的通称)每日任务就能跑一天。MR测算不仅慢,MR架构应用也有一定的开发设计新手入门门坎,因此之后又发生了一个数据信息计算方法——Hive,Hive对繁杂的MR软件开发say no!开发者只必须 懂SQL语言表达就可以开展数据信息的增删,Hive会将你的SQL句子在电子计算机具体测算前变换为MR测算每日任务,尽管速率或是一样的慢,可是减少了程序猿的开发设计门坎。

伴随着数据信息运用的逐步推进,互联网大数据管理体系的逐步完善,数据信息的使用价值愈来愈伴随着时效性而突显,因此愈来愈多的人对数据信息的及时性明确提出了高些的规定。在这类状况下,大家逐渐要求更迅速的数据信息计算方法,这就问世了之后的Impala、Presto等一系列根据纯运行内存或以运行内存为主导的测算模块,大大缩短了数据信息的解决時间,提升了数据信息特征提取的高效率,使数据信息造成了大量的商业服务额外使用价值。

大家在一些特殊情景下,针对数据处理方法的高效率规定是沒有限制的。例如,电商系统的即时强烈推荐、双十一天猫的监控大屏等,最深得人心的便是12306火车票实时统计。因此,即时流量计算公式的情景就慢慢造成了,这也激发了之后的Spark、Flink这一类即时测算模块的发亮发彩。流量计算公式就是指对不断注入的数据信息马上开展解决,可是谁也不可以确保我上下游数据信息一定是均速载入,这就必须 引进一个叫消息中间件的信息缓存部件,例如:Kafka、RocketMQ、RabbitMQ等,关键功效便是具有一个过流保护削峰的功效,就仿佛一个贮水池,针对某一时间涌进的很多数据信息开展储存,随后以一个均速的速度传送将信息分次传输到即时测算模块开展数据信息即时测算。

Spark是一个根据运行内存的测算模块。Spark的作用部件能够细分化为SparkCore、SparkSql、SparkStreaming、GraphX、MLlib。SparkCore、SparkSql主要是用于做线下数据信息批处理命令,SparkStreaming则是用于做即时流量计算公式,GraphX是用于做图计算,MLlib是一个深度学习库。Spark Streaming 适用从多种多样数据库读取数据,包含 Kafka、Flume、Twitter... ,从数据库读取数据以后,能够应用例如 map、reduce、join 和 window 等高級涵数开展繁杂优化算法的解决,最终再将数值储存到系统文件、数据库查询...中。

Flink觉得有限数据是無界数据流分析的一种充分必要条件,所以说有限数据也是一种数据流分析,事情流也是一种数据流分析。Everything is streams,即Flink能够用于解决一切的数据信息,能够适用批处理命令、流解决、AI、MachineLearning这些。

流行数据信息计算方法掌握以后,大家再从数据统计分析和大数据挖掘的视角讲一下数据信息测算。

数据统计分析,一般指剖析的总体目标较为确立,例如要从一堆学生电子档案中挑选出去性別为男的学员总数便是一种数据统计分析,是确立了x和变换涵数f的状况下来得到y值。而大数据挖掘则是根据数学模型、在给出x和y的状况下,让设备去发觉使2个值等额的的多个f涵数并运用别的数据,去持续认证得到最配对的f,最后运用f去总体目标数据开展剖析,获得掩藏的数据信息关系。

整体而言,大数据挖掘更为具备开放式,可以用于从海量信息中寻找大家沒有了解到的掩藏标准。现阶段较为常见的大数据挖掘的深度学习库关键有SparkML、FlinkML(这儿也不进行了)。

数据信息测算以后必须 以业务流程必须 的方法展现出去,那样才可以使不一样的管理决策单位运用数据信息开展輔助管理决策,因此数据展示的方法就很重要,他能危害到数据信息的形象性和数据信息的使用价值反映。而大信息系统中常见的数据展示专用工具有ECharts、Kibana等...

Echarts是百度搜索开源系统的一个根据JavaScript的数据信息可视化图表库,用以给予形象化,栩栩如生,可互动,可个性定制的数据信息可视化图表。

Kibana是ELK三件套中的展现部件(别的2个部件为:日志搜集部件——Logstash,分布式系统百度搜索引擎——Elasticsearch),给予有好的Web页面展现页面,可以使你对 Elasticsearch 数据信息开展数据可视化。

之上详细介绍了互联网大数据的总体解决步骤和相匹配步骤应用的专用工具部件。实际上除开之上数据处理方法立即有关的部件,大信息系统的平稳高效率运行还离不了一些辅助或工具性部件,例如ZooKeeper、Oozie、Hue等...

ZooKeeper通称ZK,是一个分布式架构的靠谱协调系统,在互联网大数据管理体系中运用普遍。HDFS、YARN、HBase、Kafka(将来很有可能清除ZK适用,应用内嵌取代计划方案)...等部件普遍选用ZK完成高可用性系统软件的主服务项目融洽管理方法。

Oozie和Azkaban相近,全是一个按时线程同步部件,用于管理方法Hadoop工作。Oozie能够将许多不一样的工作(如MR、Java程序流程、shell脚本制作、hivesql、sqoop、spark等)依照特殊的次序,或串行通信或并行处理的组成一个工作流引擎,名流任务完成后会全自动开启龌龊每日任务的实行,做到连贯性生产调度的目地,可以巨大的提升开发设计高效率。

Hue是一个数据可视化的互联网大数据部件系统集成,可以集成化Hive、HBase、HDFS、Spark等,完成页面数据可视化实际操作,针对数剖析技术工程师而言无需自身完成编码开发设计,立即在页面开展SQL句子实际操作或拖动实际操作就能运用这种集成化部件进行数据处理方法。

之上便是大信息系统的一个系统化详细介绍,包含了互联网大数据推动过程、数据融合步骤、云计算技术管理体系等,掌握并把握之上数据融合步骤,娴熟应用各种各样专用工具开展数据收集、储存、测算、展现,基本上就可以称得上是一个达标的大数据工程师了,假如想更多方面的发展趋势,就必须 掌握流行互联网大数据部件的特点、各种各样解决专用工具的基本原理和调优、互联网大数据部件插口的二次开发这些。

最终说一句,任何时刻都别忘记从官方网站获得大家要想了解的有关数据融合专用工具的一切特点,培养从官方网站学习培训新专业知识、新技术应用、新架构的习惯性!